openai o1 可以通过复杂的任务进行推理,并解决比以前的科学、编码和数学模型更难的问题。

它是如何运作的

通过训练模型学会完善自己的思维过程,尝试不同的策略,并认识到自己的错误。

模型在物理、化学和生物学方面具有挑战性的基准任务上的表现与博士生类似。

作为早期模型,它尚不具备 chatgpt 的许多有用功能,例如浏览网页以获取信息以及上传文件和图像。

对于许多常见情况,gpt-4o 在短期内将更加强大。

在国际数学奥林匹克(imo)资格考试中,gpt-4o 只正确解决了 13% 的问题,而推理模型的得分为 83%。

他们的编码能力在竞赛中得到评估,并在 codeforces 竞赛中达到了第 89 个百分点。

它是给谁用的

如果您正在解决科学、编码、数学和类似领域的复杂问题,这些增强的推理能力可能特别有用。

医疗保健研究人员可以使用 o1 来注释细胞测序数据,物理学家可以使用 o1 生成量子光学所需的复杂数学公式,所有领域的开发人员可以使用 o1 来构建和执行多步骤工作流程。

openai o1-mini

还发布了openai o1-mini ,这是一种更快、更便宜的推理模型,在编码方面特别有效。

作为较小的模型,o1-mini 比 o1-preview 便宜 80%

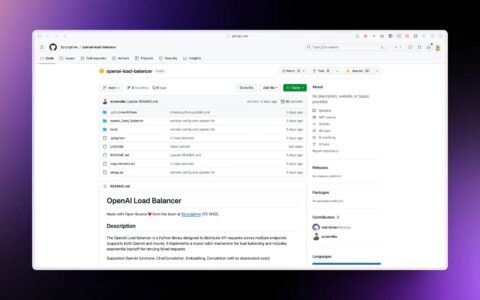

如何使用openai o1

从今天开始**,chatgpt plus 和 team**用户将能够访问 chatgpt 中的 o1 模型。

o1-preview 的每周速率限制为 30 条消息,o1-mini 的每周速率限制为 50 条。

符合api 使用第 5 层资格的开发人员今天可以开始使用 api 中的两种模型进行原型设计,速率限制为 20 rpm。

接下来是什么

除了模型更新之外,希望添加浏览、文件和图像上传等功能。

除了新的 openai o1 系列之外,还计划继续开发和发布 gpt 系列中的模型(还有活)。

jim fan 的评价

- 你并不需要一个巨大的模型来进行推理。大量的模型参数用于存储和记忆事实,从而在类似 trivia qa 这样的基准测试中表现出色。

- 大量的计算资源正在从前/后训练转移到推理服务。大语言模型本质上是基于文本的模拟器。通过在模拟器中模拟多种策略和场景,模型最终将收敛到有效的凯发k8一触即发的解决方案。

- openai 很可能早已发现推理扩展的规律,而学术界最近才开始深入研究。上个月有两篇论文相隔一周在 arxiv 上发表:

- 《large language monkeys: scaling inference compute with repeated sampling》。brown 等人发现,deepseek-coder 在 swe-bench 基准测试中的准确率从单次采样的 15.9% 提升至 250 次采样的 56%,超越了 sonnet-3.5。

- 《scaling llm test-time compute optimally can be more effective than scaling model parameters》。snell 等人指出,palm 2-s 在数学问题上的表现,通过测试时的搜索策略,击败了一个大 14 倍的模型。

- 将 o1 投入生产要比在学术基准测试中取得成功更具挑战性。对于现实世界中的推理问题,如何判断何时停止搜索?奖励函数应该如何定义?成功的标准是什么?何时应该在循环中调用像代码解释器这样的工具?如何权衡这些 cpu 过程的计算成本?他们的研究报告并没有透露太多细节。

- strawberry 可能会迅速演变为一个数据驱动的良性循环。如果搜索得到正确答案,那么整个搜索过程就会成为一个微型的训练数据集,其中包含正负奖励信号。

这将反过来增强未来版本 gpt 的推理核心,类似于 alphago 的价值网络——用于评估每个棋盘位置的优劣——随着蒙特卡洛树搜索生成越来越多精细的训练数据而不断优化。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun299496.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重