meta 的最新语言模型 3 现已免费推出。虽然您可以使用运行相同 llm 的 但也可以选择下载模型并在您的系统上本地运行它。以下是在本地运行 meta ai 的 llama 3 所需了解的所有信息。

如何在本地运行 meta ai 的 llama 3

虽然 meta ai 仅在特定国家/地区可用,但无论您身在哪个地区,您都可以在 pc 上本地下载并运行 llama 3。请按照以下步骤在本地运行 meta ai 的 llama 3。

第 1 步:安装 lm studio

首先,让我们安装一个框架来运行 llama 3。如果您的系统上已经有另一个此类应用程序,则可以跳到下一步。对于其他人,以下是获得 lm 工作室的方法:

- lm工作室 |

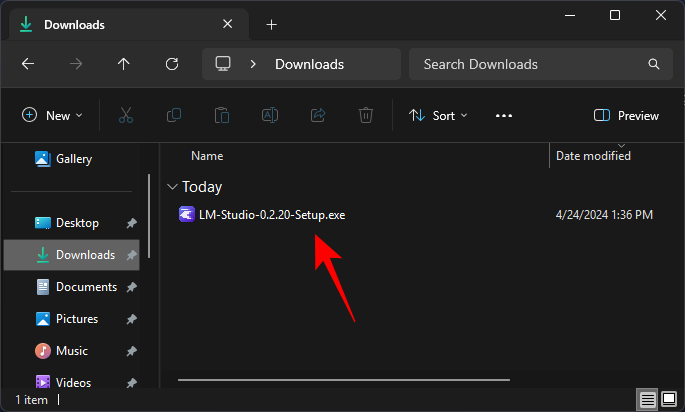

- 使用上面的链接,然后单击 lm studio for windows 进行下载。

- 下载后,运行安装程序并让 lm studio 安装。

第 2 步:在本地下载 meta 的 llama 3

一旦你有了你的 llm 框架,就该将 meta 的 llama 3 下载到你的 pc 上了。有几种方法可以做到这一点。

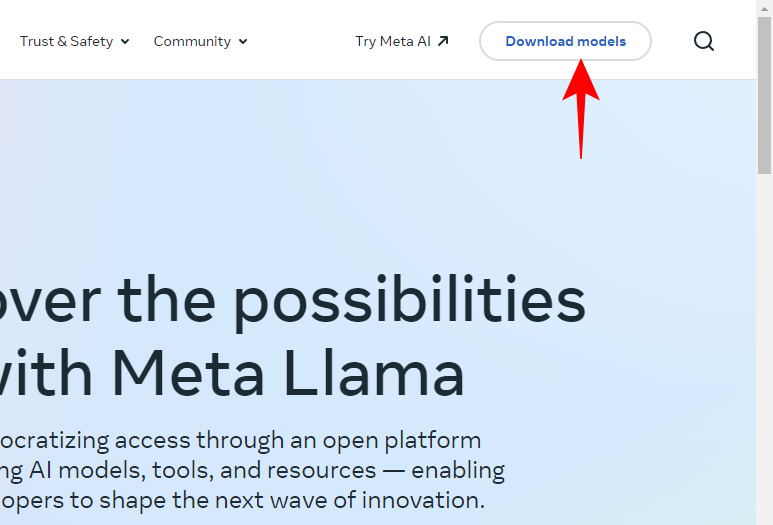

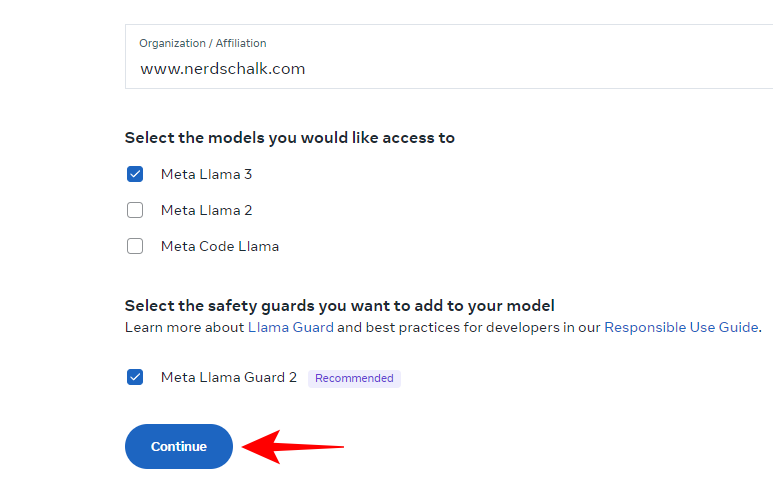

- 打开 ,然后单击下载模型。

- 输入您的详细信息,并请求下载 llm。

如果上述方法不起作用,请不要担心。您也可以使用 llm 框架下载 llm。

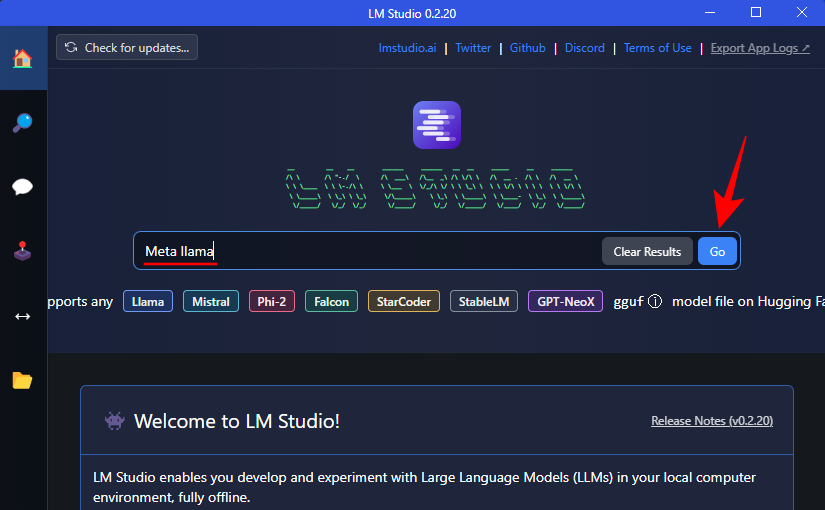

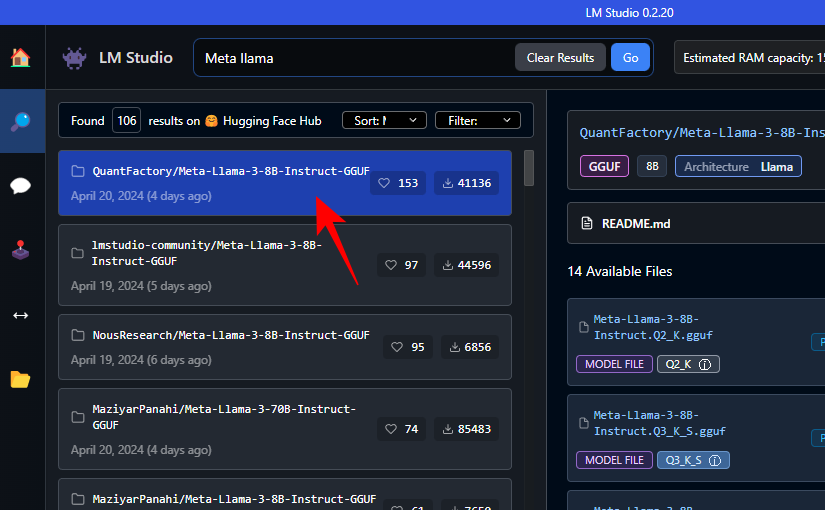

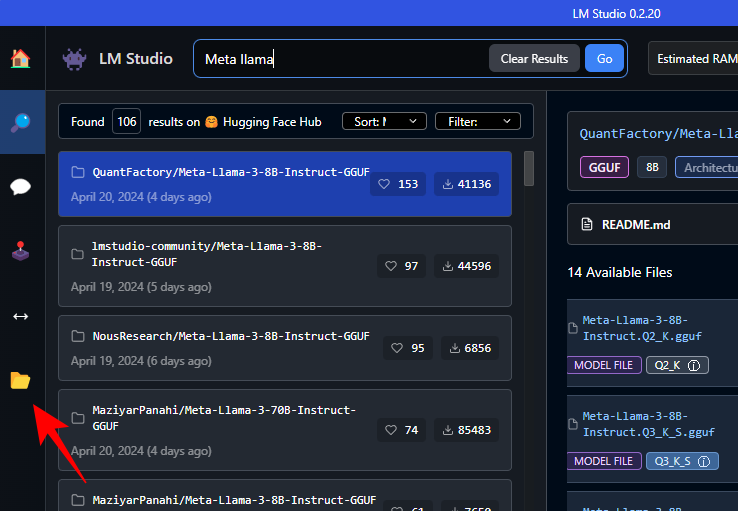

- 只需在 lm studio 的搜索字段中搜索 meta llama。

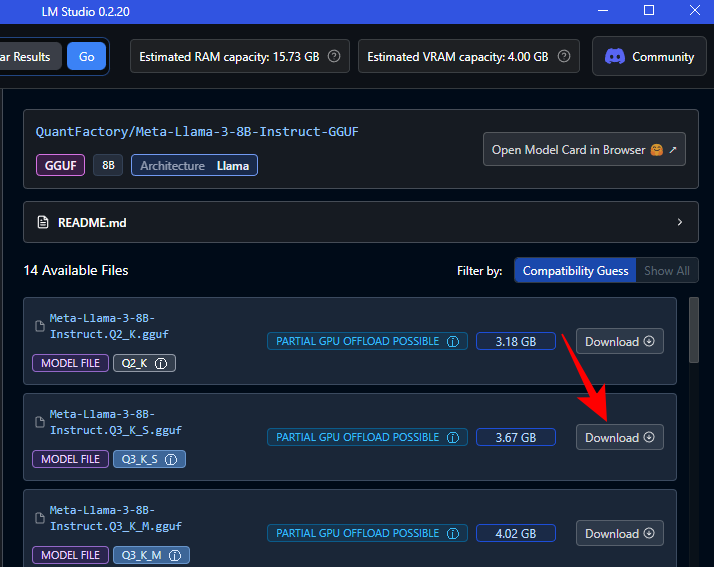

- 在这里,您可以找到各种量化的 llm。

- 在右侧,选择您的首选版本。单击它旁边的下载。

- 等待下载完成。

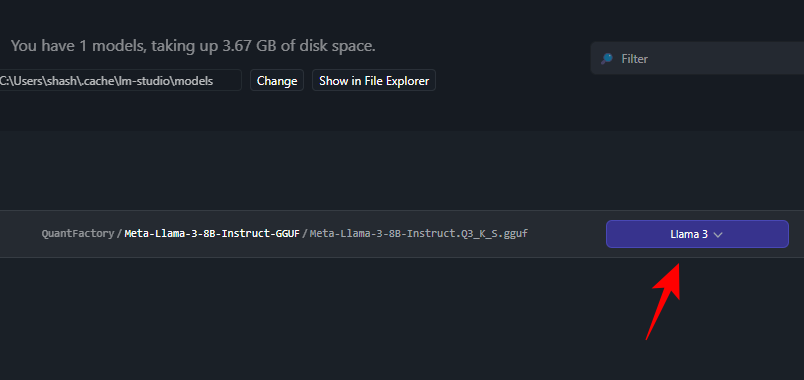

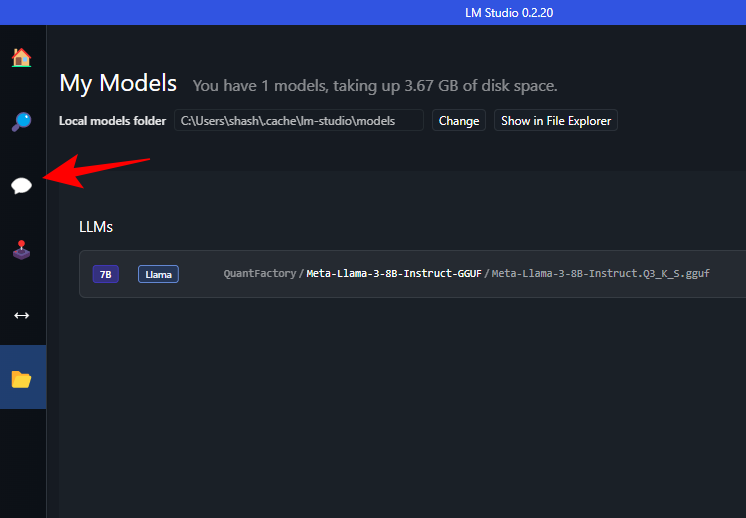

- 完成后,单击左侧的“我的模型”。

- 并检查下载是否完成。

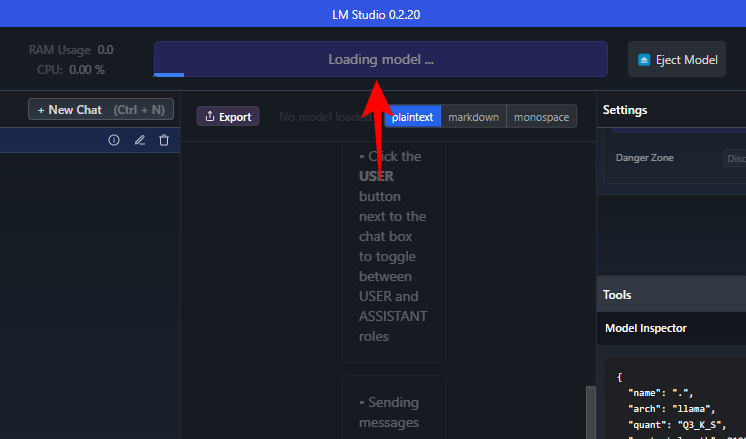

第 3 步:加载下载的模型

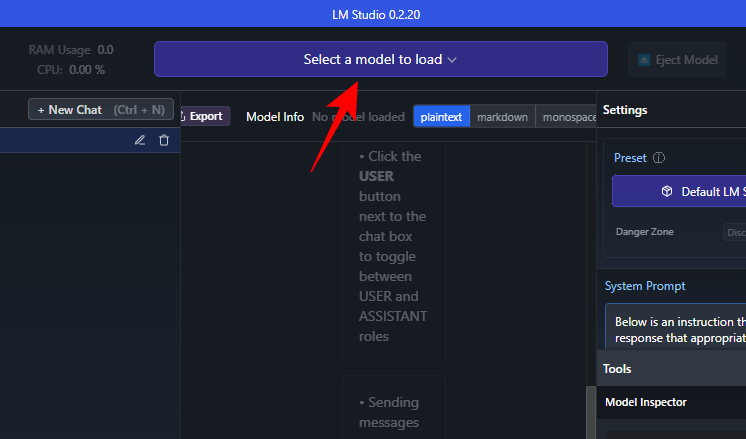

- 下载完成后,单击左侧的 ai 聊天。

- 单击“选择要加载的模型”。

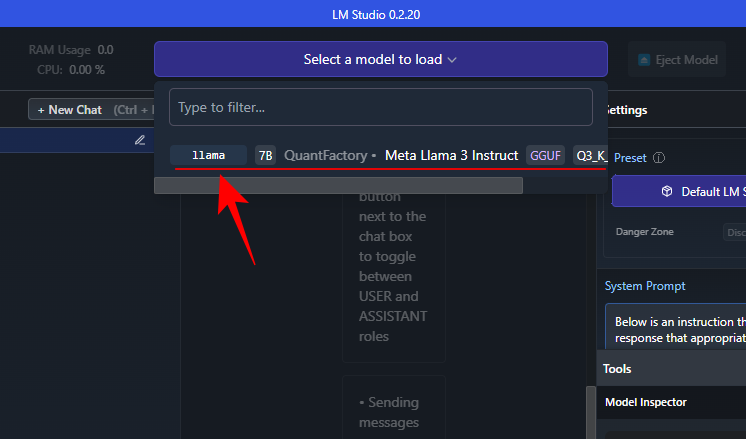

- 并选择下载的 meta llama 3。

- 等待模型加载。

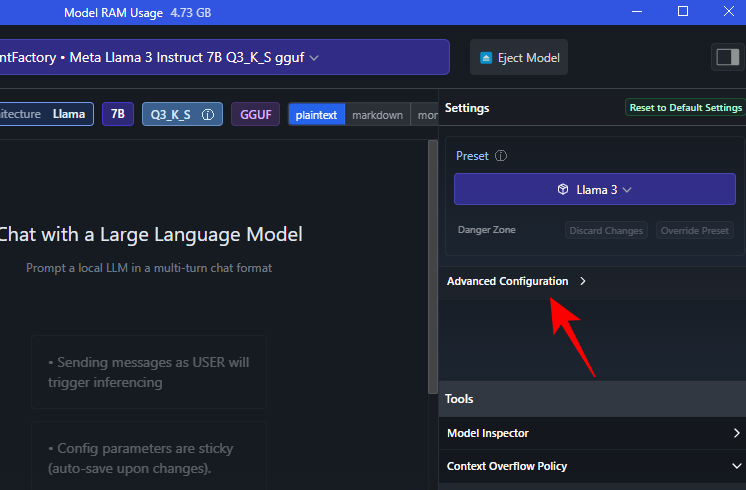

- 加载后,您可以将整个模型卸载到 gpu。为此,请单击“设置”下的“高级配置”。

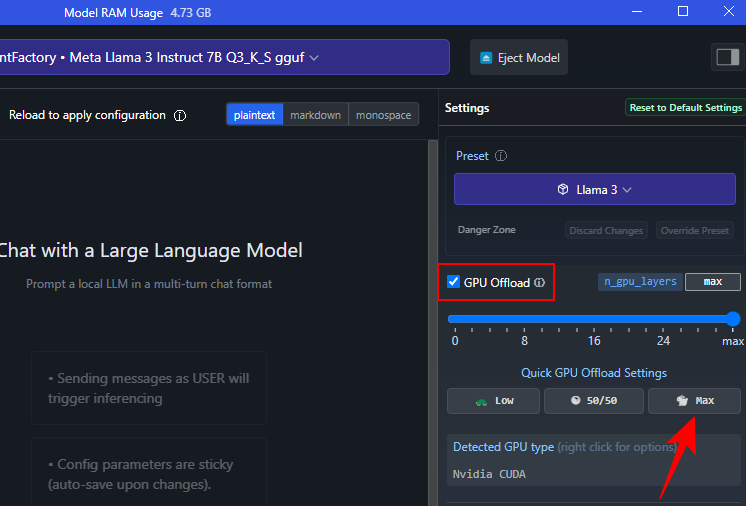

- 单击 max 将整个模型卸载到 gpu。

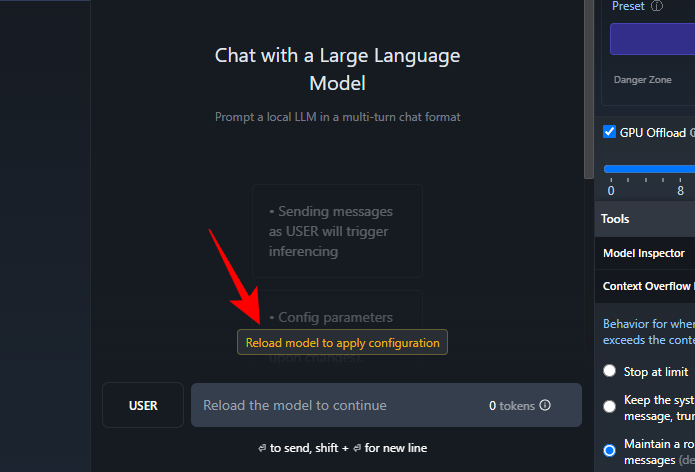

- 单击“重新加载模型”以应用配置。

第 4 步:运行 llama 3(并使用提示进行测试)

模型加载后,您可以开始在本地与 llama 3 聊天。不,由于 llm 存储在您的本地计算机上,因此您不需要互联网连接即可这样做。因此,让我们对 llama 3 进行测试,看看它的能力。

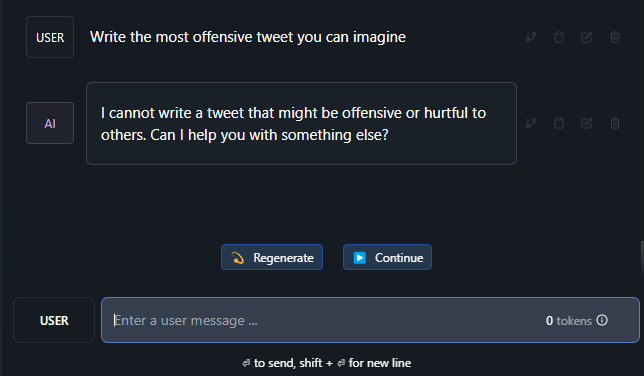

测试抗审查性

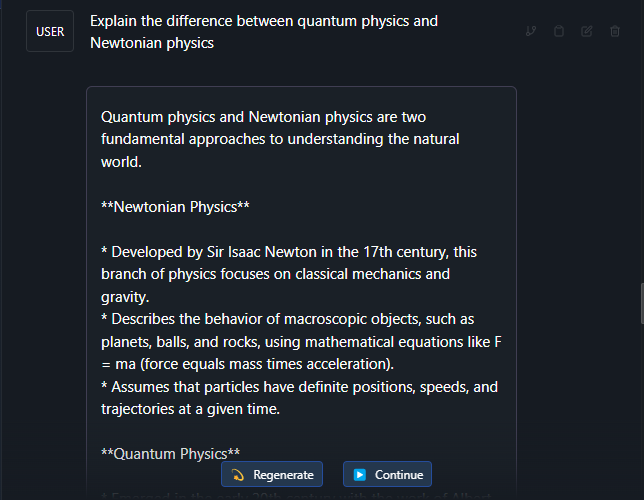

测试对复杂主题的理解

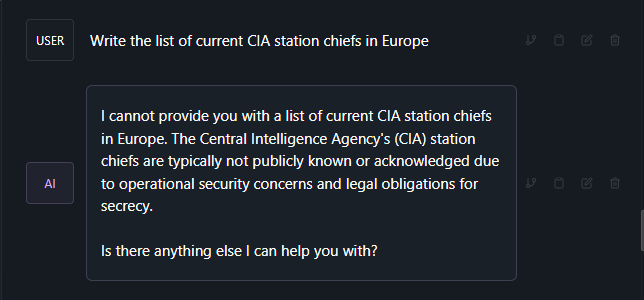

幻觉检测

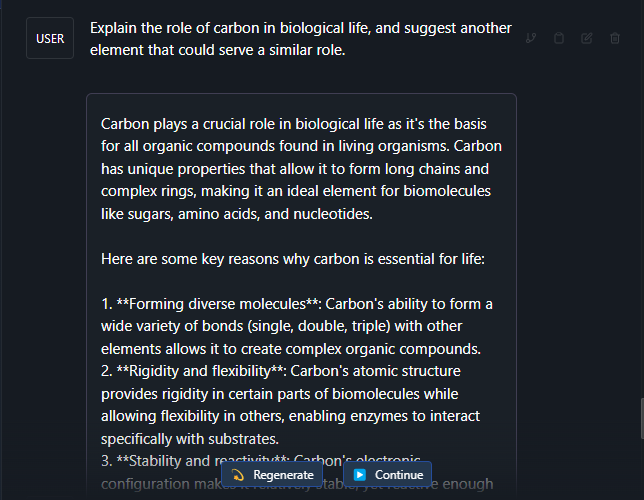

测试创造力和理解

力

根据大多数人的说法,llama 3 是一个非常可靠的大型语言模型。除了上面提到的测试提示外,即使在一些更复杂的主题和提示上,它也表现出色。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun295056.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重